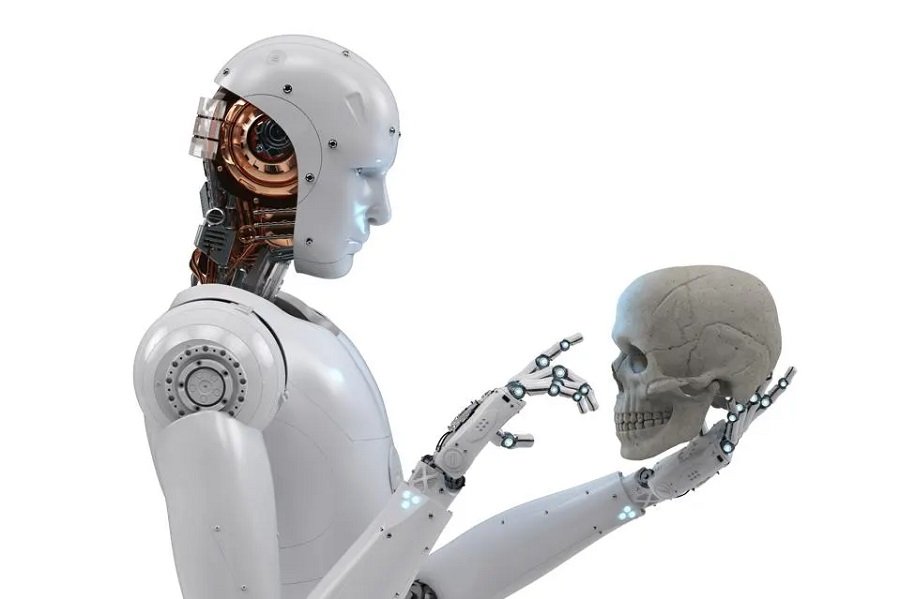

Um documento, assinado por centenas de profissionais respeitados da indústria da IA, incluindo os CEOs de OpenAI, Google DeepMind e Anthropic, levanta a questão do risco de extinção apresentado pelo desenvolvimento desenfreado da IA. Este risco, argumentam eles, deve ser uma prioridade global, em pé de igualdade com outros riscos de larga escala, como pandemias e guerras nucleares.

No entanto, essas preocupações não são compartilhadas por todos no campo da IA. Algumas vozes discordantes, como Yann LeCun, cientista-chefe de IA da Meta, argumentam que os sistemas de IA não são intrinsecamente incontroláveis. Para ele e para outros, como Andrew Ng, cofundador do Google Brain e ex-cientista-chefe do Baidu, a IA pode ser a solução para os riscos existenciais que a humanidade enfrenta, e não o problema.

Em contrapartida, outras figuras proeminentes, como Geoffrey Hinton, conhecido como “Padrinho da IA”, e Connor Leahy, CEO da Conjecture, argumentam que a IA com capacidades humanas é inevitável. Dessa forma, é imperativo tomar medidas agora para evitar futuras ameaças existenciais.

No entanto, há uma ambiguidade em torno de quais ações precisas os signatários da declaração esperam. Com CEOs e líderes de quase todas as principais empresas de IA, além de acadêmicos renomados, assinando o alerta, está claro que o objetivo não é interromper o desenvolvimento desses sistemas potencialmente perigosos.

A discussão também está se estendendo para o campo legislativo. Recentemente, Sam Altman, CEO da OpenAI, e um dos signatários do documento, fez sua primeira aparição perante o Congresso. Durante a audiência, ele fez um apelo por regulamentação no setor de IA.

O impacto de Altman no campo da IA estende-se além de seu papel na OpenAI. Seu projeto, Worldcoin, que integra criptomoedas e prova de personalidade, tem atraído atenção significativa. Recentemente, levantou US$ 115 milhões em uma rodada de financiamento da Série C, aumentando o financiamento total para impressionantes US$ 240 milhões.