O cenário das fraudes no mercado de criptomoedas passou por uma transformação alarmante em 2024, impulsionado pelo avanço das deepfakes geradas por inteligência artificial. De acordo com o relatório Anti-Scam 2025, elaborado pela corretora Bitget em parceria com Slowmist e Elliptic, esse tipo de golpe foi responsável por 40% dos casos de fraudes classificadas como “de alto valor” no ano passado.

Os prejuízos totais no universo cripto chegaram a US$ 4,6 bilhões em 2024, representando um aumento de 24% em relação ao ano anterior. A Bitget aponta que as fraudes evoluíram e passaram a se apoiar não apenas em brechas tecnológicas, mas também na manipulação da confiança e na exploração da psicologia das vítimas.

Uma das armadilhas mais recorrentes envolve o uso de vídeos falsificados de figuras públicas. O relatório cita, por exemplo, montagens em que o CEO da Tesla, Elon Musk, aparece promovendo falsos investimentos ou sorteios fraudulentos. Além dele, deepfakes de autoridades governamentais, celebridades e bilionários são usados para criar identidades falsas, burlar processos de verificação (como KYC) e aplicar golpes por meio de reuniões falsas no Zoom.

Esses golpes por videoconferência funcionam de forma elaborada. Os criminosos se passam por executivos, jornalistas — incluindo repórteres da Decrypt — ou especialistas de renome, convidando a vítima para uma suposta entrevista de emprego ou participação em uma reportagem fictícia. Durante a chamada falsa, os atacantes conseguem tomar o controle do computador da vítima, roubar dados sensíveis e até acessar chaves privadas de carteiras de criptomoedas.

O uso de inteligência artificial permite que áudio e vídeo sejam manipulados de forma tão convincente que muitos não percebem se tratar de uma fraude. Embora golpes desse tipo não sejam exatamente uma novidade — o famoso golpe envolvendo deepfakes de Elon Musk viralizou já em 2022 —, a qualidade das falsificações aumentou drasticamente com o avanço das ferramentas de IA.

O crescimento desse problema chegou a gerar repercussões legais. No mês passado, o ex-presidente dos EUA, Donald Trump, sancionou o Take It Down Act, uma legislação bipartidária focada em proteger vítimas de pornografia criada por IA. No entanto, vale destacar que o uso de deepfakes de maneira geral ainda não é totalmente proibido por lei.

Casos recentes envolvendo celebridades também escancaram a gravidade da situação. Em maio, a atriz Jamie Lee Curtis denunciou publicamente o CEO da Meta, Mark Zuckerberg, após encontrar um anúncio publicitário falso, criado por IA, usando sua imagem sem autorização para divulgar um produto.

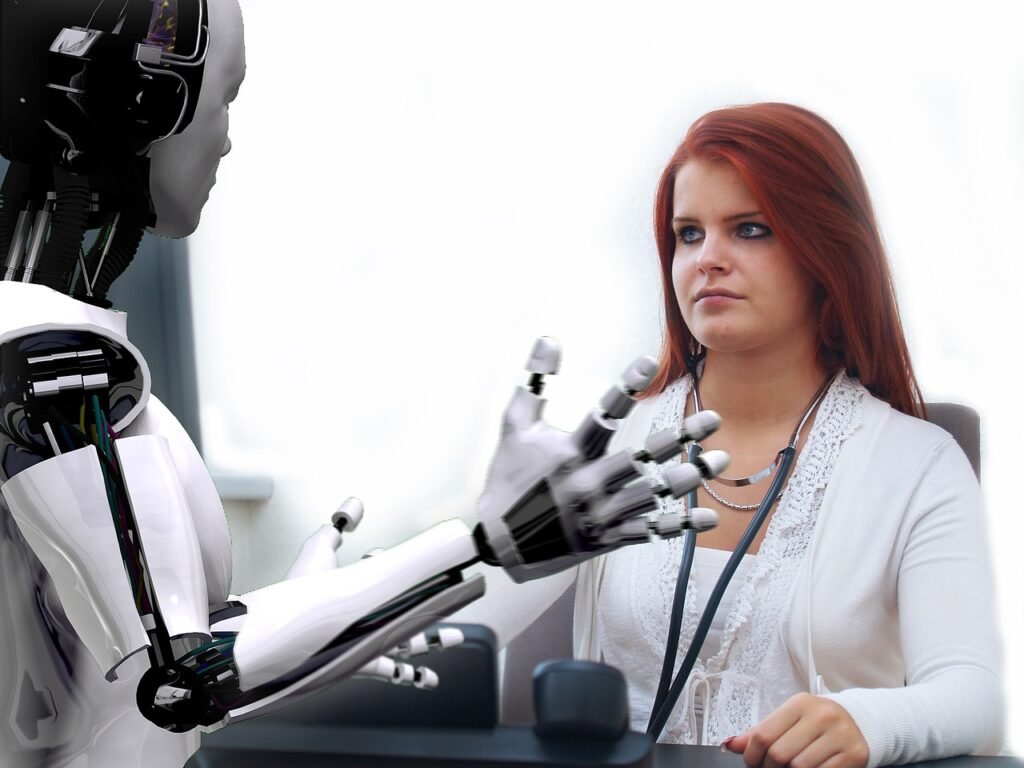

Para a CEO da Bitget, Gracy Chen, o maior risco atual para o mercado de criptomoedas não é mais a volatilidade, mas sim o engano. “A inteligência artificial tornou os golpes mais rápidos, mais baratos e muito mais difíceis de serem detectados”, declarou.

Além das deepfakes, o relatório também identificou outros dois métodos de fraude particularmente perigosos: os esquemas de engenharia social e as versões modernas dos esquemas Ponzi. A engenharia social, embora de baixa tecnologia, se mostra extremamente eficaz por explorar aspectos emocionais e psicológicos das vítimas. Um dos exemplos mais conhecidos é o golpe do “pig butcher” (açougueiro de porcos), também chamado de golpe romântico, no qual o golpista constrói um relacionamento afetivo com a vítima para, no fim, aplicar o golpe.

Os tradicionais esquemas Ponzi também passaram por uma transformação digital. Embora mantenham a lógica clássica de usar dinheiro de novos participantes para pagar os antigos, eles agora se disfarçam em projetos ligados a tendências como DeFi, NFTs, GameFi e promessas de rendimentos via mineração de liquidez ou staking de tokens. Segundo o relatório, esses golpes se apresentam como oportunidades legítimas, mas assim que o fluxo de dinheiro se interrompe — seja porque os operadores “dão o golpe final” e somem, seja porque faltam novos investidores — todo o sistema colapsa rapidamente.

O relatório alerta ainda para uma tendência crescente de golpes que adotam interfaces que imitam jogos, tornando-se mais atrativos para o público. Para aumentar a credibilidade, os criminosos recorrem também a deepfakes, simulando endossos de celebridades.

A conclusão do documento não poderia ser mais direta: se há cinco anos a principal recomendação de segurança era “não clique em links suspeitos”, hoje ela evoluiu para “não confie nem no que você vê”.